Apache Sqoop – Big Data Analytics Ferramentas de big data analytics do ecossistema hadoop O Apache Sqoop intermedia o Hadoop file system e bancos relacionais (SGBDR) Esse é o link da documentação oficial: http://sqoop.apache.org/ Continuando Vamos agora importar todas as tabelas do retail_db do mysql para o hdfs no formato Avro. Na aula passada foi explicado […]

Apache Sqoop Ferramentas do ecossistema Hadoop para big data analytics Mas afinal, o que é sqoop? Para que serve o sqoop? E quando devo usar o sqoop? Espero que esse post deixe todas essas perguntas bem claras para vocês. Então, vamos a um pouco de sua história. O Apache Sqoop (TM) foi projetado para transferir […]

Análise de sentimento com Flume e Twitter QUARTA PARTE Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link do meu Github: https://github.com/toticavalcanti CONTINUANDO COM A CONSTRUÇÃO DA APLICAÇÃO DE ANÁLISE DE SENTIMENTO. CONSTRUÇÃO DO SCRIPT PYSPARK PARA A ANÁLISE FOI UTILIZADO O SPARK, UMA TECNOLOGIA DE COMPUTAÇÃO DISTRIBUÍDA EM CLUSTER, EXTREMAMENTE RÁPIDA. EXISTEM MUITOS MÉTODOS E […]

Análise de sentimento com Flume e Twitter TERCEIRA PARTE Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link do meu Github: https://github.com/toticavalcanti CONTINUANDO COM A CONSTRUÇÃO DA APLICAÇÃO DE ANÁLISE DE SENTIMENTO. COMO VAMOS UTILIZAR O HIVE, VAMOS CONHECER UM POUCO SOBRE ELE HIVE O HIVE É UM SISTEMA DE DATA WAREHOUSE OPENSOURCE, USADO PARA CONSULTAR […]

Análise de sentimento com Flume e Twitter SEGUNDA PARTE Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link do meu Github: https://github.com/toticavalcanti VAMOS TENTAR USAR O TIPO DE SOURCE com.cloudera.flume.source.TwitterSource AO INVÉS DO org.apache.flume.source.twitter.TwitterSource SEM FAZER NENHUMA MODIFICAÇÃO NA MÁQUINA CLOUDERA . NO ARQUIVO flume_twitter.conf VAMOS DESCOMENTAR A LINHA ABAIXO, RETIRANDO A TRALHA (#) DO INÍCIO: TwitterAgent.sources.Twitter.type = […]

Análise de sentimento com Flume e Twitter PRIMEIRA PARTE Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link do meu Github: https://github.com/toticavalcanti AVISO: As 3 aulas a seguir referentes a Análise de sentimento com Flume e Twitter, infelizmente não funciona mais na prática, a máquina cloudera usada na aula ficou desatualizada e foi descontinuada pela empresa. […]

Ingestão de dados com o Flume Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link do meu Github: https://github.com/toticavalcanti DEFINIÇÃO O FLUME É UM SERVIÇO DE INGESTÃO DE DADOS PARA COLETAR, AGREGAR E TRANSPORTAR GRANDES QUANTIDADES DE FLUXO DE DADOS (STREAMING), COMO POR EXEMPLO: ARQUIVOS DE LOG, EVENTOS, DADOS DE REDES SOCIAIS, SENSORES, ETC. DE […]

Wordcount com PySpark Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link do meu Github: https://github.com/toticavalcanti Essa aula é uma continuação da passada, vamos fazer a mesma coisa executar só que ao invés de digitar comando por comando no Shell PySpark como fizemos na aula passada, iremos salvar o script inteiro em um arquivo .py, podemos […]

Contagem de palavras com PySpark Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link do meu Github: https://github.com/toticavalcanti O SPARK É UMA ESTRUTURA DE PROCESSAMENTO BIG DATA, OPENSOURCE DESENVOLVIDA PARA TER VELOCIDADE, FACILIDADE DE USO E POSSIBILTAR ANÁLISE DE DADOS SOFISTICADAS O SPARK PODE SER 100X MAIS RÁPIDO QUE O HADOOP PARA PROCESSAMENTO DE DADOS EM […]

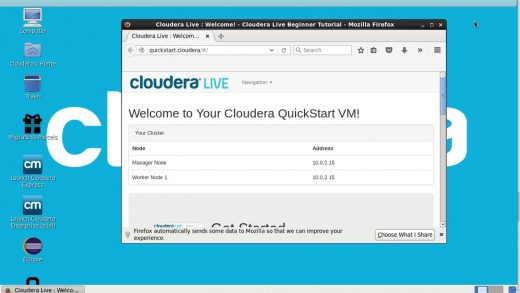

Configuração da máquina Cloudera Link para o download da máquina: https://www.cloudera.com/downloads/quickstart_vms/5-13.html Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link para download do virtual box: https://www.virtualbox.org/wiki/Downloads/ Link para o download do putty: https://www.putty.org/ Link para o download do WINSCP: https://winscp.net/eng/download.php Link do meu Github: https://github.com/toticavalcanti Arquivo zipado Configurações da máquina cloudera Depois de unzipar o arquivo, […]

HDFS,YARN e os tipos de nós Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link para o download do putty: https://www.putty.org/ Link para o download do WINSCP: https://winscp.net/eng/download.php Link do meu Github: https://github.com/toticavalcanti COMPONENTES PRINCIPAIS DO HADOOP O HADOOP POSSUI DOIS COMPONENTES PRINCIPAIS QUE IMPLEMENTAM O ARMAZENAMENTO E O PROCESSAMENTO DISTRIBUÍDO: O HDFS QUE GERENCIA OS […]

Configuração da máquina Cloudera Link para o download da máquina: https://www.cloudera.com/downloads/quickstart_vms/5-13.html Link da documentação oficial do Hadoop: http://hadoop.apache.org/ Link para o download do putty: https://www.putty.org/ Link para o download do WINSCP: https://winscp.net/eng/download.php Link do meu Github: https://github.com/toticavalcanti Arquivo zipado Configurações da máquina cloudera Depois de unzipar o arquivo, é necessário fazer algumas configurações Acessando a […]

Introdução ao Map-Reduce Link da documentação oficial: http://hadoop.apache.org/ Github: https://github.com/toticavalcanti O MAPREDUCE DIVIDE VOLUMES IMENSOS DE DADOS EM PARTES PEQUENAS, QUE SÃO ENTÃO ESPALHADAS POR MUITOS COMPUTADORES EM VEZ DE MOVER DADOS PARA UM SOFTWARE DE PROCESSAMENTO – O QUE SERIA LENTO COM VOLUMES GRANDES DE DADOS – O PROCESSAMENTO É MOVIDO PARA ONDE ESTÃO OS DADOS, […]

Introdução ao Hadoop File System Links da documentação oficial: http://hadoop.apache.org/ Github: https://github.com/toticavalcanti HADOOP – INTRODUÇÃO É UMA PLATAFORMA DE COMPUTAÇÃO DISTRIBUÍDA VOLTADA PARA CLUSTERS E PROCESSAMENTO DE GRANDES VOLUMES DE DADOS É UM SISTEMA OPERACIONAL PARA BIG DATA CÓDIGO ABERTO CRIADO POR DOUG CUTTING DO GOOGLE LABS EM 2005 CRIAÇÃO MOTIVADA PELO DESAFIO DA ESCALABILIDADE PARA CONSEGUIR […]

Certificação Hortonworks Hadoop FS – Certificação HDP hortonworks Simulado da prova de certificação HDP Hortonworks TAREFA 10 Exportando com Sqoop Coloque o arquivo local /home/hortonworks/datasets/flightdelays/sfo_weather.csv no HDFS em um novo diretório chamado /user/hortonworks/weather/ Note que existe uma base de dados MySQL chamada flightinfo na máquina namenode, contendo uma tabela chamada weather com o esquema mostrado […]

Certificação Hortonworks Hadoop FS – Certificação HDP hortonworks Simulado da prova de certificação HDP Hortonworks TAREFA 09 Tabelas particionadas Hive Escreva uma consulta Hive em um arquivo chamado /home/horton/solutions/weather_partitioned.hive que satisfaça os seguintes critérios: Defina uma nova tabela Hive chamada weather_partitioned que tenha o mesmo esquema da tabela sfo_weather A tabela é particionada nas colunas […]

Certificação Hortonworks Hadoop FS – Certificação HDP hortonworks Simulado da prova de certificação HDP Hortonworks TAREFA 08 Hive Join Escreva uma consulta Hive em um arquivo chamado /home/horton/solutions/flights_weather.hive que satisfaça os seguintes critérios: Use Tez as the execution engine O resultado da consulta deve gerar uma nova tabela Hive chamada flight_weather armazenada como um arquivo […]

Certificação Hortonworks Hadoop FS – Certificação HDP hortonworks Simulado da prova de certificação HDP Hortonworks TAREFA 07 Definir e preencher uma tabela ORCFile Defina uma tabela Hive chamada sfo_weather que satisfaça todos os seguintes critérios: Uma tabela gerenciada pelo Hive Os dados são armazenados no formato ORCFile A tabela deve ser preenchida com os registros […]

Certificação Hortonworks Hadoop FS – Certificação HDP hortonworks Simulado da prova de certificação HDP Hortonworks TAREFA 06 Analisando dados com o Hive Escreva uma consulta em HiveQL e salve as consultas em um único arquivo de texto chamado /home/horton/solutions/flightdelays.hive para cada uma das tarefas abaixo: Calcule o arrdelay médio dos voos que desembarcam em Denver […]

Certificação Hortonworks Hadoop FS – Certificação HDP hortonworks Simulado da prova de certificação HDP Hortonworks TAREFA 05 Use HCatalog com Pig Escreva um script Pig e salve na máquina local em /home/horton/solutions/flightdelays_nonzero.pig que satisfaça todos os seguintes critérios: Execute uma consulta Pig usando o Tez como o mecanismo(engine) de execução Carregue os dados da tabela […]